一种融合注意力机制的苗族服饰图案分割方法

万林江,黄成泉,张博源,王 琴,周丽华

(1.贵州民族大学 数据科学与信息工程学院,贵州 贵阳 550025;

2.贵州民族大学 工程技术人才实践训练中心,贵州 贵阳 550025)

民族服饰文化是各族人民的劳动成果、色彩喜好、风俗特点和宗教信仰等各种文化交融的体现,是中国传统文化必不可少的一部分。苗族服饰文化是其中最具代表性的文化之一。苗族服饰图案丰富多彩,有着较高的艺术审美价值,且蕴含着一代又一代人对美好事物的期望。苗族服饰图案在不同的历史时期、不同的区域都有着区别与变化,不管是图案样式,还是制作手法,都有着独属于自己民族和地方的风格特点。

分割出精准的苗族服饰图案,能有效地将苗族服饰图案进行数字化保存,对苗族服饰文化的分析和解读等研究具有重要意义。图像分割的主流定义就是将图像进行切割,将图像采用某种标准进行区域划分(这些区域相互之间都不交叉),并从中提取出感兴趣的目标。目前的图像分割技术已经被广泛地应用在生活中,如人脸识别[1]、医学影像[2]、无人驾驶[3]等。在现有的服饰图案研究中,大部分是从人文的角度通过综述的形式对苗族服饰的重要性进行阐述;

或者通过基于模糊C均值聚类[4]和主动轮廓[5]等传统方法对苗族服饰图案进行分割研究。在以往研究中,主要根据图案的色彩、纹样等的相似性进行分割,其在分割效率和精度上,与深度学习还有一定的差距。也有少部分人利用深度学习的方法对服装等图案进行分割,例如:徐莹珩等[6]和游小荣等[6]运用神经网络的方法在复杂背景下对服装图案进行有效的分割。但是运用深度学习对苗族服饰图案进行分割的方法少之又少,苗族服饰图案具有多元化的特点,其包含着独特的纹样、图腾、纹理等重要的元素特征。运用深度学习有效且准确地对苗族服饰图案进行分割具有极大的挑战性。

针对上述问题,本文提出一种SegNet模型与注意力机制相结合的苗族服饰分割算法(称为SE-SegNet)。尝试用该算法加强模型对图像前景区域的关注,以增强对特征信息的保留和融合,进而提高苗族服饰图案的分割精度。本文为少数民族服饰图案的分割研究提供了一种有效可行的方法。

深度学习模型在计算机领域的成功应用,吸引了大量的科研人员来研究运用深度学习的方法进行图像分割,图像分割技术因此诞生了许多开创性成果。Long等[8]提出了一种全卷积网络(FCN),其实现过程是基于端到端实现,奠定了语义分割在深度学习中的重要地位。FCN是基于VGG-16[9]网络的进一步研究,引入了Skip layer,实现了像素级别的分类。但FCN的计算效率低,不能有效地获取到图像的全部特征信息。Badrinarayanan等[10]在FCN的基础上提出了SegNet模型,它的核心是由1个编码器网络(VGG-16网络的13个卷积层,去掉了全连接层)和1个与之对应的解码器网络构成。SegNet通过最大池化来增加感受野,记录并保存相应位置的最大池化索引,在解码器中使用储存的索引,可在一定程度上提高分辨率。Ronneberger等[11]提出了一种U型网络结构(U-Net),上采样过程与下采样过程对应,并融合了特征信息,对每一张图像进行了逐像素的预测,在图像分割方面获得了良好的表现。

随着深度学习的快速发展,各种网络模型在图像分割方面展现出优异的性能。Zhao等[12]提出的PSPNet,融合特征图的上下文信息,能够获得较好的全局特征。Chen等[13-15]提出的DeepLabv系列网络模型,在图像处理过程中引入空洞卷积[16]并进行改进,融合了更多的特征信息。Hu等[17]在SENet模型中提出了SE模块,通过特征通道的信息,压缩和激励每个通道的权重,并将权重应用到对应的通道中,增强了模型对特征信息的提取。Oktay等[2]在UNet的结构上融入了注意力机制(Attention UNet),通过注意力加强对目标区域的关注,抑制背景区域,分割性能显著提升。Fu等[18]提出了双注意力融合网络(DANet),融合了位置注意力模块和通道注意力模块,通过2个模块在特征图中的相互联系进行加权,将其输出进行融合,使得分割效果得到极大的改善。

2.1 SE注意力模块

SE注意力模块主要由Squeeze和Excitation部分组成。Squeeze部分在特征图进行卷积操作后再进行全局平均池化(GAP);

Excitation部分将通道权重放入Sigmoid函数中,在区间内进行映射,也就是归一化处理过程。SE模块是从特征图的通道入手,根据每个通道的影响程度进行划分,加强影响程度较大的特征通道的关注,抑制影响程度较小的特征通道的关注。

SE注意力模块如图1所示。X表示输入图像;

U表示输出图像;

C、W、H分别表示图像的通道数、宽度和高度;

C′、W′、H′分别表示卷积操作Ftr之前的C、W;

Fsq(·)表示对U进行GPA操作(Squeeze部分);

Fex(·,W)表示用2次全连接对Squeeze得到的1×1×C数据进行映射变换(Excitation部分);

Fscale(·,·)表示将Excitation输出的归一化权重与U对应的每个特征通道进行加权。

图1 SE(Squeeze-and-Excitation)注意力模块Fig.1 SE (Squeeze-and-Congestion) attention module

2.2 SegNet模型

SegNet模型的编码器部分包括卷积层、批标准化(Batch Normalisation)、激活函数、池化层。卷积层可获得图像的特征图,有助于提取轮廓等特征信息;

Batch Normalisation有助于特征图数据信息的稳定和权重的学习;

池化层用于存储索引、降低维度和增加模型的鲁棒性。解码器部分包括上采样、卷积层、批标准化、激活函数。将存储的索引和相应的特征图通过池化层进行上采样,把低分辨率特征图转换为高分辨率特征图。SegNet模型的解码器与编码器可分为相对应的5个部分:第1、2部分分别包含2个卷积层,第3、4、5部分分别包含3个卷积层,共13个卷积层相对应。本文算法在SegNet模型的基础上进行改进,去除了第3、4部分相对应的1个卷积层以及第5部分相对应的3个卷积层。本文算法的网络结构的编码器与解码器分别有8个卷积层一一对应,每个卷积层均有Batch Normalisation,线性整流函数(ReLU)作为激活函数,卷积核大小为3×3。编码器的卷积层分为4部分,每部分含有最大池化层;

解码器通过编码器的Pooling储存的索引进行上采样,模型最后一个卷积层接一个非线性函数Sigmoid作为激活函数,优化器为随机梯度下降法(SGD)。经过实验,减少卷积层后的SegNet模型用于苗族服饰图案分割,在一定程度减少了内存消耗,其交并比(IoU)值为0.821 5,Dice系数为0.902 0,分割效果高于SegNet模型。本文在改进的SegNet模型中的编码器与解码器之间融入了SE注意力模块。如图2所示,解码器部分的输出作为注意力模块的输入,该模块根据通道之间的相关性,加强了对特征信息的关注,减少了重要信息的损失。

图2 改进的SegNet模型结构Fig.2 Improved SegNet model structure

2.3 交叉熵损失函数

交叉熵损失函数在权重更新方面表现出优异的性能,权重更新根据误差的变化而变化。误差大时;

更新快,误差小时,更新慢。交叉熵损失函数可用在不同的分类问题中,数学表达式一般分为2类。二分类问题中的loss函数为

(1)

多分类问题中的loss函数为

(2)

式中:x表示样本;

y表示样本x的标签;

a表示样本预测的输出;

n表示样本总数量。

3.1 数据集

实验数据集为苗族服饰数据集,数据集包含训练集和测试集2部分,图像大小均为512×512。实验数据集来源于北京服装学院民族服饰博物馆,通过数据增强进行扩充,最终得到实验数据集共506张,其中,训练数据集占80%,共405张;

测试数据集占20%,共101张。实验数据集标签来源于文献[5]。

3.2 环境及参数设置

实验环境为Ubuntu 14.04、CUDA 10.1、Python 3.6、Pytorch 1.7.1,CPU频率为4.2 GHz,GPU显卡为GeForce GTX 1080 Ti,显存为8 GB。模型训练Epochs设为35,Batch Size设为4,学习率为1e-2,随机梯度下降法作为模型的优化器,损失函数为交叉熵损失函数。

3.3 实验评价指标

为了对本文算法性能进行一个评判,便于与其他分割模型进行对比,使用5个指标作为实验的评估标准:①像素准确率(PA);

②交并比(IoU);

③相似系数(Dice);

④敏感度(Sensitivity);

⑤精确率(Precision)。计算方法见式(3)~(7):

(3)

(4)

(5)

(6)

(7)

式中:TP表示预测为真,实际为真;

TN表示预测为假,实际为假;

FP表示预测为真,实际为假;

FN表示预测为假,实际为真。

3.4 结果与分析

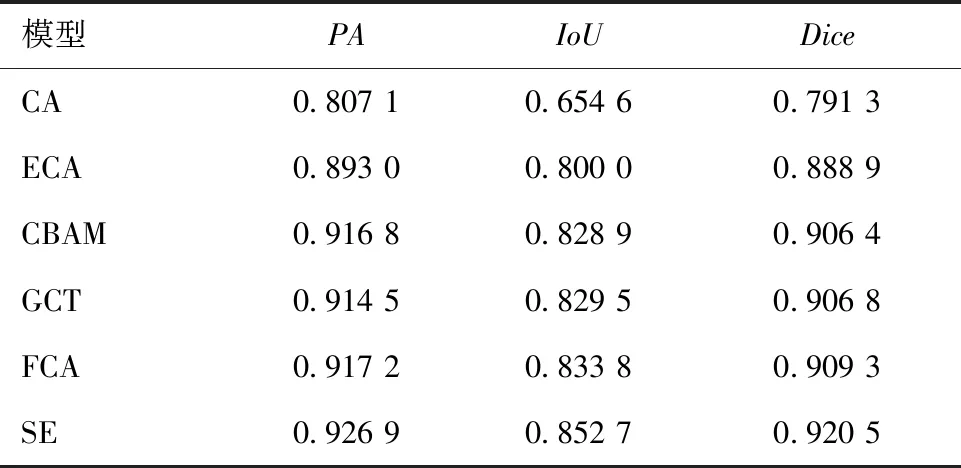

当模型训练Epochs为35轮时,改进后的SegNet网络模型效果达到最优(还未融入注意力机制,PA为0.912 7,IoU为0.821 5,Dice为0.902 0)。为了测试不同注意力机制在本文改进的SegNet模型中的分割效果,将6个不同的注意力模块融入改进后的SegNet网络并进行对比。表1示出不同注意力模块的分割结果。可见:CA[19]和ECA[20]注意力模块在改进模型中的效果较差,降低了模型的分割精度;

当融入CBAM[21]、GCT[22]和FCA[23]注意力模块时,模型的分割精度变化不大,无明显的提升效果;

当融入SE[17]注意力模块时,与改进的SegNet模型相比,IoU提高了3.80%,Dice提高了2.05%,模型的分割效果提升显著。实验结果表明,SE注意力模块能有效提高本文模型的分割性能。

在同等实验条件下,根据3.3节所述5个评价指标,将本文模型SE-SegNet与SegNet[10]、U-Net[11]、ENet[24]、LinkNet[25]、ESPNet[26]、EDANet[27]和DABNet[28]7个网络模型进行比较,结果如表2所示,从PA、IoU和Dice这3个重要评价指标来看,本文提出的SE-SegNet网络模型的分割结果优于其他7个网络模型,敏感度及精确率高于大部分网络。SE-SegNet的分割结果与其他网络相比,PA至少提高了2.04%,IoU至少提高了5.14%,Dice至少提高了2.78%。实验表明,提出的SE-SegNet模型适用于苗族服饰数据集的分割,且有着优异的分割性能。本文是基于SeNet模型进行改进的,与SegNet模型相比,SE-SegNet模型的PA提高了2.86%,IoU提高了6.72%,Dice提高了3.62%,敏感度提高了7.70%,精确率的值略低于SegNet模型。

表1 不同注意力模块的分割结果Tab.1 Segmentation results of different attention modules

表2 苗族服饰数据集在不同网络模型中的分割结果Tab.2 Segmentation results of Miao clothing data set in different network models

本文将SE-SegNet与实验对比网络(PA值为0.88以上的网络)的分割图片进行可视化,如图3所示,分别选取了7张具有代表性的图片,第1行和第2行分别是苗族服饰图案的原图和标签,第3~6行是本文模型和对比模型的分割结果,可以看出改进后的模型分割结果优于其他网络,其在细节方面分割取得了良好的成绩,但在苗族服饰图案内容比较复杂(如第5列原图对比度低;

第6、7列原图颜色差异大,且颜色种类多)时,分割效果略差于U-Net模型,但是U-Net模型在细节方面的分割略差于本文改进后的SegNet模型。

图3 不同网络模型的分割结果视觉对比图Tab.3 Visual comparison of segmentation results of different network models

本文提出了一种基于改进SegNet模型的苗族服饰图案分割方法SE-SegNet,通过对骨干网络SegNet进行改进,减少内存消耗,提高分割效率;

并在模型的上采样开始时融入了一个SE注意力模块,利用特征通道之间的相关性,根据不同通道的权重大小,获取到不同通道的重要程度,提高了模型对细节信息的处理能力;

为了加强苗族服饰图案细小纹理的分割,采用了二分类交叉熵损失函数,极大地减少了细节信息的丢失。实验证明,改进后的模型分割效果优于U-Net、SegNet和ESPNet等7个模型。虽然本文算法对苗族服饰图案的分割精度有一定的提高,但是对图案色彩差异大且颜色种类多的图像分割效果不理想,因此下一步的研究重点将是如何提高色彩差异大且颜色种类多的苗族服饰图像的分割精度。

栏目最新:

- 2024年度在理论学习中心组关于群众路线...2024-01-16

- 在退役军人事务工作领导小组会议上讲话...2024-01-15

- 中秋国庆队伍教育管理工作动员部署会议...2024-01-15

- 2024年度区委书记在文旅农康融合发展大...2024-01-14

- 医院纪检监察干部队伍教育整顿个人党性...2024-01-14

- 教师演讲稿:牢记育人使命,涵养高尚师德...2024-01-13

- 2024年组织部长在市委理论学习中心组专...2024-01-13

- 2024年区人民法院案件质量评查办法(2篇...2024-01-13

- 2024年区长在指导某街道干部作风建设动...2024-01-11

- 在公司成立周年大会上讲话(3篇)(完整...2024-01-10

相关文章: